–

E’ già da qualche tempo che desideravo scrivere un articolo che parlasse della fondamentale fase preparatoria delle immagini astronomiche, cioè il pre-processing conosciuto anche col nome di calibrazione. Il motivo che mi ha spinto a sfruttare queste uggiose giornate autunnali per porvi rimedio è che non ho mai trovato su internet una guida che spigasse quali sono i reali calcoli fatti dai software di elaborazione senza sfociare in formule giganti comprensibili solo ad ingegneri o astrofisici. Si trova tanta documentazione che spiega la calibrazione in modo discorsivo ed altrettanta che sembra uscita da un trattato Universitario, mai una via di mezzo. Il primo documento che mi ha permesso di capire cosa è davvero la calibrazione è un lavoro di Paolo Maria Ruscitti, astrofisico e coordinatore della torre delle stelle. Dopo la lettura di quel documento lo contattai subito per complimentarmi e da lì nacque subito una bellissima amicizia online. Qua sotto riporto una copia del suo trattato (nel caso qualcuno volesse approfondire ulteriormente). Dopo diversi mesi avevo ancora dei dubbi su come alcuni scatti di calibrazione (chiamati flat frames) lavorassero per divisione sulle foto. Su questo ho ricevuto l’imbeccata giusta da Roberto Sartori, programmatore, revisore e sviluppatore di PixInsight, anche lui tanto geniale quanto umile e disponibile! Ma veniamo a noi e spieghiamo cosa è questa benedetta calibrazione.

PREMESSA

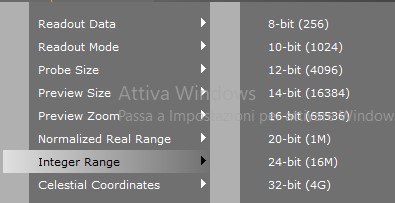

Quando si scattano delle foto non si fa altro che misurare la quantità di luce emessa o riflessa da un soggetto con l’uso di un sensore digitale composto da pixel. Ogni pixel o fotodiodo di questo sensore rileverà una certa quantità di luce (fotoni) che sarà poi tradotta in unità digitali da salvare nella nostra memory card, hard disk o pen drive. Queste unità digitali chiamate ADU (Analog to Digital Units) esprimono il valore di luminosità che poi dovrà avere sullo schermo quel pixel. Logicamente a seconda della profondità in bit della nostra fotocamera avremo immagini più o meno accurate. Una fotocamera a 2 bit sarà in grado di registrare solo 4 diversi livelli di luminosità mentre una da 4 bit ne potrà registrare 16. Una fotocamera da 14 bit potrà registrare 16384 differenze di tonalità mentre una da 16 bit registrerà 65536 livelli di luminosità (sempre espressi in ADU). Viene facile capire che se devo misurare una sorgente luminosa la fotocamera a 16bit mi restituirà valori molto più accurati rispetto a quella da 2bit e le immagini ne gioveranno tantissimo in qualità. In PixInsight, programma che uso in modo prevalente, è possibile misurare in modo diretto i valori dei pixel della nostra immagine. Nella barra in basso compaiono le coordinate del pixel selezionato e di fianco i valori dei canali RGB espressi in ADU. Nota che io, come tanti altri, per comodità, utilizzo i valori normalizzati da 0 ad 1, dove 1 è il valore massimo di luminosità e 0 è quello minimo. In una camera a 16bit quindi 1=65536 ADU e 0=0 ADU. Anche molti, credo tutti, i processi di PixInsight eseguono la normalizzazione prima di fare i calcoli, ed è per questo che quasi sempre ci troveremo a lavorare su processi che ci restituiscono numeri costituiti da uno zero, la virgola ed a seguire una certa quantità di numeri. Tuttavia negli esempi numerici che seguiranno, per formalità, non userò valori normalizzati ma interi espressi in ADU.

Nonostante la tecnologia ci fornisca elettronica sempre più performante non potremo mai avere delle strumentazioni esenti da errori fisici che andranno ad incidere sulle nostre misurazioni. Questi errori di misurazione saranno ancora più visibili se associati alle fotografie di oggetti deboli come nebulose o galassie lontane anni luce e non percepibili neppure ad occhio nudo; magari l’errore di misurazione avrà valori in ADU addirittura superiori ai valori veri di luminosità del soggetto fotografato, il che diventa estremamente lesivo sulla qualità delle foto del profondo cielo. Per fortuna la teoria della calibrazione ci viene incontro permettendoci di annullare quasi del tutto alcuni di questi errori fino a renderli insignificanti. Vediamo quindi quali sono gli errori che si possono eliminare e come farlo!!!!!

_______________________________________________________________________________________________

PARTIAMO DALLA FINE: L’INTEGRAZIONE NON FA PARTE DELLA CALIBRAZIONE!!!

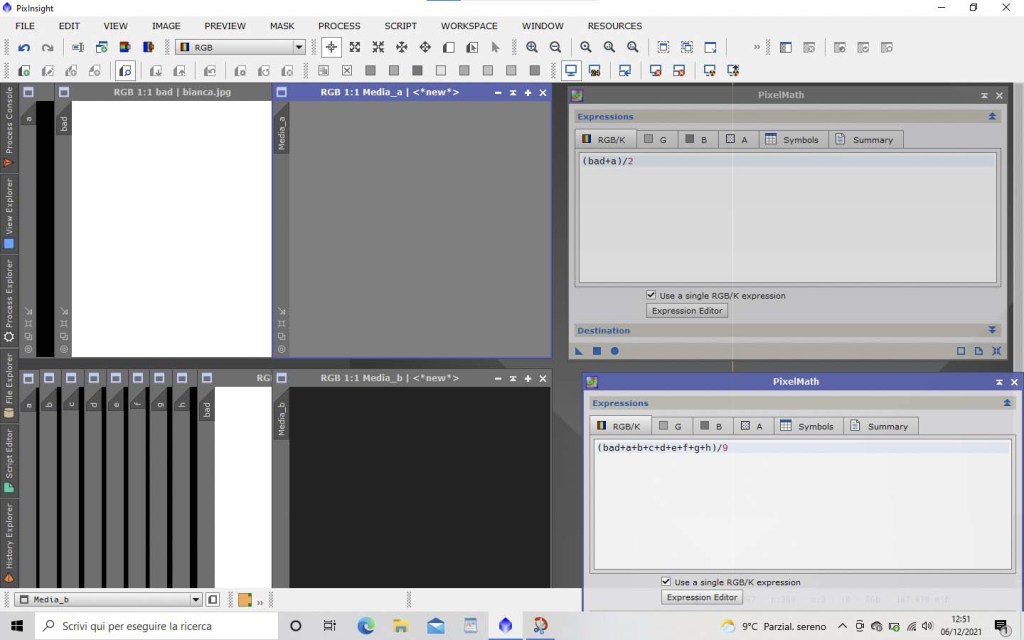

Il primo errore di misurazione con cui si imbatte il nostro sensore astronomico è il rumore fotonico. Ne parlo prima degli altri errori perchè questo oltre che essere il primo è anche quello che non può essere eliminato. Esso dipende dall’incertezza con la quale la luce arriva a noi…..; non dipende perciò dai nostri strumenti ma da “forze superiori” e non si può eliminare del tutto in fase di calibrazione proprio perchè è inquantificabile; grazie alla tecnica dell’integrazione, però, possiamo ridurlo drasticamente. Spieghiamo prima cosa è per poi capire come ridurlo. Non tutti lo sanno ma una sorgente luminosa non emette sempre la stessa quantità di fotoni. Essa è come un fiume, e nessun fiume ha la stessa portata d’acqua nello stesso identico istante. Per misurare la portata di un fiume si dovrà fare una stima media. Supponiamo che in un determinato momento in un preciso punto del fiume passino 1000 litri d’acqua al secondo. Non è detto che dopo 10 minuti ne passino sempre 1000, magari ne passano solo 500 al secondo. Allora quale sarà il valore medio della portata del fiume? La media ci dice che passeranno (1000+500)/2= 750 litri al secondo. Questo non è ancora un valore attendibile perché ho effettuato poche misurazioni. Se quando ho effettuato la misurazione di 500 era attiva una chiusa più a monte avrò rilevato un valore estremamente errato. Allora supponiamo di effettuare altre 8 misurazioni con questi valori: 1100, 900, 1100, 900, 1100, 900, 1100, 900. Ora facendo la media ottengo una portata di 950 litri al secondo: (1000+500+1100+900+1100+900+1100+900+1100+900)/10 = 950. Direi che il dato ora è molto più attendibile, ma possiamo fare di meglio. Possiamo eliminare i dati spuri, errati o perlomeno quelli che ci sembrano tali, in modo da ottenere una media più robusta. Questa operazione nei software astronomici si chiama rejection ed è ampiamente diffusa in statistica. Praticamente rigetta (taglia) nel vero senso della parola tutti valori che non rientrano in un range di valori considerati validi. Questo range di valori viene chiamato sigma. Con poche parole prendono subito significato quegli algoritmi di rigetto come il taglio K-Sigma, il winsorized sigma clipping etc. che si vedono tanto spesso nei software di elaborazione astronomica (questi tipi di algoritmi, che funzionano in modo simile tra loro, li vedremo nel dettaglio prossimamente). Concludiamo la questione dell’integrazione dicendo che alla fine (dopo aver escluso quel 500) la vera media di tutti i valori sopra elencati è evidente che sia 1000. Lo stesso tipo di media viene fatta con i valori dei pixel delle nostre foto astronomiche: ogni livello di luminosità misurato su un pixel ed espresso in ADU può essere confrontato con il pixel corrispondente di un’altra foto scattata allo stesso soggetto con la stessa inquadratura. E’ come se impilassimo in una catasta tante foto uguali (chiamati LIGHT o SUBFRAMES) per poi fare la media della catasta di ogni signolo pixel. Infatti in inglese si dice fare lo Stack di tante foto (dove stack vuol dire proprio pila o catasta). Mediando tutti i LIGHT frames otterremo la foto cosiddetta INTEGRATA (ora quando si parlerà di integrazione sappiamo a cosa ci si riferisce). NOTA: più foto avremo da integrare, più misurazioni dei soggetti astronomici saranno disponibili. Più misurazioni saranno disponibili e più otterrò risultati attendibili. Più i miei risultati saranno attendibili e più la mia foto integrata (detta MASTER LIGHT) sarà pulita e priva di quella grana fastidiosa, conosciuta anche dai fotografi tradizionali, col nome di RUMORE. Se non fosse ancora chiaro con le parole e con i numeri controlla la foto in basso. Ho simulato la media di due immagini dove assumiamo che quella nera sia il cielo e bella bianca un’immagine rovinata, inattendibile. La loro media ci darà un master che sarà l’esatta via di mezzo, cioè grigio chiaro. Se invece avessimo un set di dati più ampio da mediare, supponiamo 9 immagini, il master risultante sarà sicuramente una rappresentazione più affidabile del nostro cielo, rendendo quasi insignificante la foto bianca e riportando valori di luminosità prossimi ai veri valori di nero. Ecco, questo è quel che succede a livello di pixel quando li impiliamo e facciamo la loro media in fase di integrazione.

Però per poter fare i calcoli che abbiamo appena visto dobbiamo ripulire ogni dato dagli errori di musurazione cui può essere afflitto. L’eliminazione degli errori si chiama calibrazione, e fa parte del pre-processing. L’integrazione finale fa parte della post-produzione invece. Il fatto di aver introdotto subito il concetto di integrazione ci aiuterà anche a capire meglio come generare i file MASTER di calibrazione chiamati BIAS, DARK, FLAT e FLATDARK che vedremo in seguito.

_______________________________________________________________________________________________

IL PRE-PROCESSING: ERRORI DA CORREGGERE CON LA CALIBRAZIONE.

Abbiamo detto che al fine di ottenere un’unica immagine integrata di buona qualità avremo bisogno di tante foto dello stesso soggetto, i cosiddetti sub-frames o LIGHTS. Questi sub frames devono essere ripuliti da tutte le misurazioni di luce errate! Noi vogliamo che alla fine della calibrazione rimanga solo il segnale luminoso PURO, quello del soggetto astronomico, in modo tale da mediare solo il segnale vero, non le schifezze prodotte dai giocattoli costruiti da noi miseri mortali!!!!!! 😀 Vediamo quali sono questi errori, abbiamo già tergiversato troppo!

- LIVELLO DI BIAS O OFFSET

- ERRORI DI LETTURA

- ERRORI TERMICI DOVUTI ALLA CORRENTE DI BUIO (DARK CURRENT)

- AMP-GLOW

- SPORCIZIA O POLVERE SUL SENSORE O NEL TRENO OTTICO

- VIGNETTATURA

Per spiegare quali sono e come si accumulano gli errori accennati qua sopra bisogna dire che la luce che colpisce il sensore viene trasformata in elettroni. Ogni fotone che incide sul fotodiodo infatti libera una certa quantità di elettroni che saranno contati da un convertitore analogico-digitale chiamato ADC (Analog to Digital Converter). Il conteggio di tali elettroni verrà usato per scrivere le unità digitali corrispondenti da salvare sulla mia pen-drive, i cosiddetti ADU di cui parlavamo prima. In un mondo ideale il nostro sensore sfrutterà ogni singolo fotone (magari……) per produrre un elettrone che a sua volta verrà contato e trasformato in 1 ADU., ma cosi’ non è e dobbiamo porvi rimedio.

_______________________________________________________________________________________________

IL LIVELLO DI BIAS E RUMORE DI LETTURA. Per motivi squisitamente tecnici i nostri sensori, per poter funzionare bene, aggiungono sempre un certo numero di elettroni di base per non partire da valori troppo bassi. La quantità di elettroni aggiunti dal nostro sensore si chiama livello di BIAS. Quando scattiamo le nostre foto quindi ci saranno gli elettroni prodotti dal livello di BIAS e quelli liberati dalla sorgente di luce (i responsabili dell’impressione dell’immagine sul sensore). Gli elettroni prodotti però non saranno mai contati in modo precisissimo dall’elettronica e quindi verranno tradotti in ADU con un certo errore. Oramai i moderni sensori c-mos hanno errori di lettura quasi trascurabili, dell’ordine di + o – 1 elettroni a gain (ISO) bassi; tuttavia questi errori ci sono e possono essere ridotti, se non addirittura annullati, drasticamente; vediamo come. Supponiamo di scattare tante foto con il sensore al buio e con i tempi minimi impostabili sulla fotocamera. Ecco, abbiamo appena acquisito i nostri BIAS FRAMES: in questi scatti non ci sarà segnale luminoso ma verrà registrato solo il livello di bias affetto da un piccolo rumore di lettura casuale. Per i principi visti nel paragrafo dell’integrazione noi possiamo fare la media di questi scatti in modo da ridurre drasticamente il rumore di lettura ed ottenere solo il livello di BIAS; abbiamo appena ottenuto il MASTER BIAS, un’unico scatto prodotto dalla media di tanti BIAS e perciò quasi esente dai rumori di lettura. Ora il valore di BIAS può essere sottratto alle nostre foto per lasciare solo il segnale puro prodotto dai fotoni dell’immagine che abbiamo fotografato. Questo si può fare con la formula che vedi sotto.

PixLight-PixMasterBias

Anzi no… aspetta un attimo!!! Siamo solo all’inizio! Ci sono altri rumori che devono essere sottratti. Il BIAS era solo il primo! Un’altro disturbo che viene aggiunto dall’elettronica e che andrà sottratto in fase di calibrazione è la corrente di BUIO, comunemente chiamata rumore termico. Nel prossimo paragrafo spieghiamo cosa è.

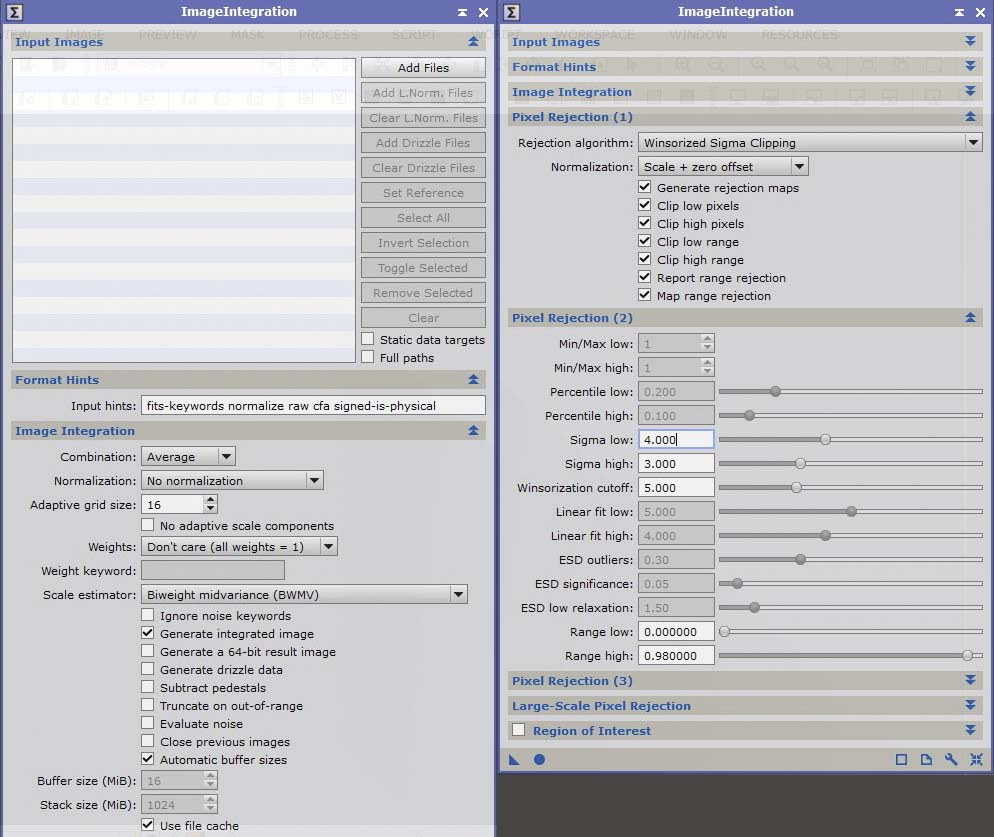

Per creare il MASTER BIAS segui le indicazioni che seguono usando ImageIntegration di PixInsight:

- Aggiungere i nostri frames scuri cliccando su Add Files.

- Non normalizzare le immagini: il software deve lavorare con i dati espressi in ADU. La normalizzazione trasformerebbe questi valori in numeri decimali compresi da 0 ad 1 con un serio pericolo di arrotondare quelli più bassi a 0, condizione da evitare assolutamente.

- Non assegnare un peso alle immagini: la media dei valori di ogni singolo pixel deve essere pura e non condizionata da fattori di peso.

- Rejection attiva: anche se i frame scuri sono acquisiti al buio è possibile comunque trovare componenti esterne che vanno tagliate. Un esempio su tutti sono i raggi cosmici che passano anche col tappo inserito sull’obbiettivo.

- NOTA: gli stessi parametri devono essere usati per integrare DARK e DARKFLAT.

_______________________________________________________________________________________________

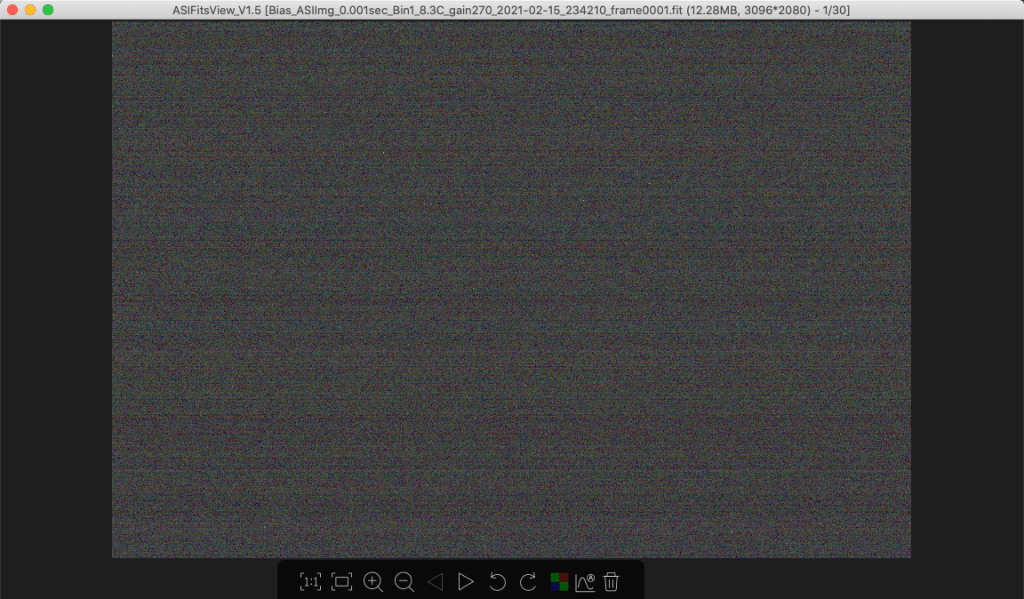

LA DARK CURRENT, NOTA ANCHE COME RUMORE TERMICO. Scattare fotografie della durata di diverse decine di secondi produce un certo surriscaldamento dell’elettronica. Più uno scatto è lungo e più si creerà calore, che ,eccitando gli elettroni dell’Hardware, si staccheranno e finiranno assieme a quelli prodotti per effetto fotoelettrico, cioè quelli generati dalla luce, causando un certo disturbo nell’immagine. Considera che anche al buio più completo, se scaldato, il nostro sensore creerà un certo flusso di elettroni. Questo flusso viene detto DARK CURRENT e l’ eccesso di elettroni, visualizzato a schermo nella foto, creerà una grana chiamata, comprensibilmente, rumore termico. Nelle fotografie diurne il fenomeno si nota poco poichè sono molto luminose ed il rumore termico viene letteralmente sovrastato dal segnale in arrivo. Inoltre giovando di una grossa quantità di luce non sarà necessario scaldare troppo il sensore con scatti lunghissimi. Qualche frazione di secondo sarà sufficiente per immortalare un paesaggio. Ma uno scatto rivolto al cielo, di notte, della durata di 5 minuti o più, rivelerà molta grana. Logicamente su uno sfondo scuro come il cielo il rumore termico sarà più evidente a causa del rapporto tra bassi ADU del cielo ed alti ADU prodotti dagli elettroni termici. Una soluzione adottata dalle fotocamere astronomiche è il raffreddamento, che aiuta ma di certo non fa sparire del tutto il rumore! Il raffreddamento pero’ sarà comodo per attenuare la temperatura del sensore e tenerla costante grazie ad un termostato. Il resto del rumore termico residuo potrà essere calcolato e scalato dalle foto mediante alcuni scatti di calibrazione chiamati DARK FRAMES. Un DARK viene acquisito tappando l’obiettivo, cioè evitando che arrivino fotoni sul sensore, e facendo una foto della stessa durata, allo stesso gain (leggi ISO se usi reflex) e SOPRATUTTO alla stessa temperatura della foto da calibrare. Questo scatto conterrà solo i valori degli elettroni liberati per eccitazione termica, più l’offset e gli errori di lettura visti nel paragrafo precedente.

Il raffreddamento con termostato è estremamente comodo per scattare dei DARK alla stessa identica temperatura dei LIGHT, infischiandocene delle variazioni della temperatura ambientale. Nota che se calibriamo la nostra foto con il dark non è necessario usare il master BIAS perché, come detto poco fa, il dark contiene già i valori di BIAS e gli errori di lettura della fotocamera. Un solo DARK però non può restituire dei valori assoluti perfetti: un certo pixel a volte catturerà 300 elettroni termici, altre vole 340 etc…! Per ottenere una stima accurata di quanto la nostra fotocamera sia sensibile al surriscaldamento dobbiamo fare la media di molti dark frame, ottenendo un MASTER DARK FRAME, che tramite la media ridurrà anche gli errori di lettura visti nel paragrafo dei BIAS; Il MASTER DARK appena ottenuto calibrerà il nostro light per sottrazione. E’ doveroso aggiungere che alcuni componenti posti vicino al sensore, come ad esempio l’amplificatore di segnale ed il contatore analogico digitale (ADC) possono creare ulteriore riscaldamento, portando aloni chiari sugli scatti proprio in loro corrispondenza. Questa disuniformità nell’errore termico è chiamato AMP-GLOW e nella foto sotto è parecchio evidente!

I valori in ADU dove è presente l’AMP-GLOW sono chiaramente più alti ma anche loro saranno scalati dalle nostre foto proprio grazie al master dark!!!! Il master dark inoltre rivela pixel bruciati che non registrano nessun tipo di segnale (questi avranno valori prossimi a zero ADU) e pixel cosiddetti caldi, più sensibili degli altri in modo anomalo, che saranno molto più luminosi dei vicini e con valori in ADU estremamente alti. Tutti questi errori di misurazione (bias, rumore termico ed amp-glow) saranno sommati in ogni singolo pixel del DARK. Poi, come già detto prima, verrà fatta una media dei DARK per ottenere il MASTER DARK, che conterrà dei valori statisticamente molto più affidabili di detti errori. Infine i valori presenti nel MASTER DARK saranno sottratti pixel per pixel ai LIGHTS. Aggiungo ancora che Pixel Caldi e freddi possono resistere anche dopo la calibrazione ed affliggere i LIGHT, ma si può porre rimedio mediante la Cosmetic Correction in PixInsight usando proprio il master dark come riferimento. Come si diceva prima i soggetti del profondo cielo sono molto deboli e tutti gli errori causati dall’elettronica possono letteralmente affogare quella bellissima e debole galassia che vogliamo catturare! Per questo è di primaria importanza calibrare bene i nostri subframes!!! La formula è la seguente.

PixLight-PixMasterDark

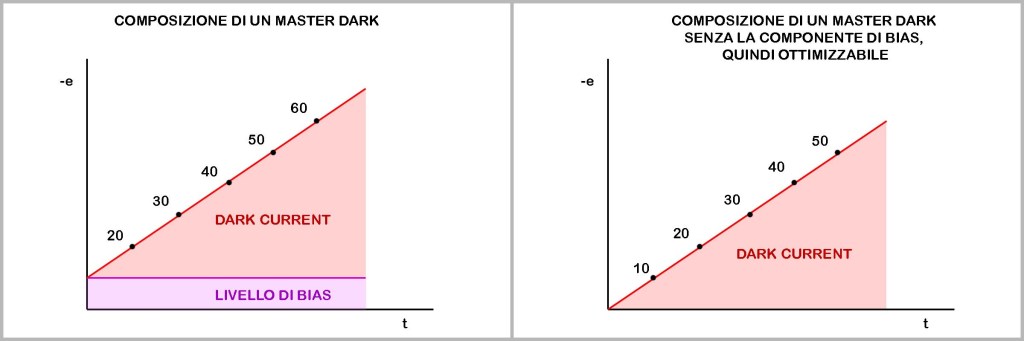

Inoltre un principio che non molti conoscono del rumore termico, ma che secondo mè è una figata pazzesca, è che esso ha una crescita costante (LINEARE) nel tempo, perciò è prevedibile! Guarda i grafici sotto e capirai subito: se io so che il rumore termico cresce di 10 elettroni al secondo allora con 5sec di esposizione avrò 50 elettroni termici da sottrarre al mio LIGHT FRAME. Questo ci permette di sfruttare un’opzione poco usata nei software di calibrazione: l’OTTIMIZZAZIONE DEL DARK FRAME. Praticamente tutti acquisiscono i DARK con la stessa durata dei LIGHT, ma grazie al processo di ottimizzazione si può usare un DARK anche di tempi diversi rispetto al light, e questo può essere comodo in alcune circostanze. Precondizione essenziale se si vuole ottimizzare un DARK con tempi diversi è avere un MASTER BIAS da dare in pasto al processo per essere sottratto al dark. Questo perchè, come detto più volte, il master dark contiene anche il BIAS oltre che il rumore termico e finché non fornisco i valori di BIAS al software esso non saprà cosa dovrà riscaldare e come. Questa sottrazione ci permette di isolare la sola DARK CURRENT per essere poi adattata ai tempi dei LIGHT.

I valori di BIAS che stanno sotto ai valori di DARK CURRENT fanno variare parecchio il rapporto di crescita totale del rumore nel tempo. Ma se noi li sottraiamo al DARK otterremo un dark perfettamente ottimizzatile con tutti i LIGHT che vorremo, a prescindere dai loro tempi di acquisizione. Cosa vuol dire questo? Se analizziamo gli elettroni in eccesso, dopo 1 secondo avremo 20-e (solo il 50% prodotti dalla DARK CURRENT), dopo 3sec avremo 40-e ( 75% prodotti dalla DARK CURRENT) e dopo 5sec avremo 60-e ( l’83% generati da DARK CURRENT). Una lettura del genere è palesemente sbagliata se vogliamo scalare i valori della corrente termica e basta. Avendo però il valore di BIAS il software lo potrà sottrarre al dark per isolare la dark current e scalarla in base alle esigenze di ottimizzazione!!!!!!

Ricorda che per integrare i DARK, al fine di ottenere MASTER DARK, devi usare l’istanza di ImageIntegration con gli stessi parametri usati per i BIAS visti al paragrafo precedente.

_______________________________________________________________________________________________

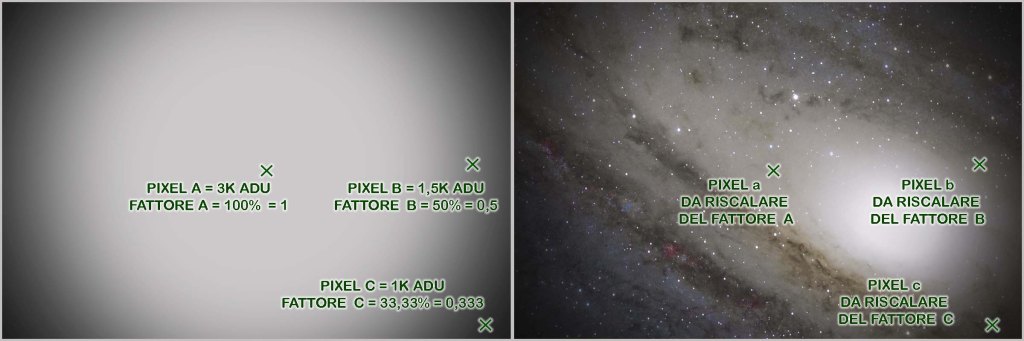

LA VIGNETTATURA invece è quella caduta di luminosità che si nota ai bordi dell’immagine ed è provocata da tutto il treno ottico. Si può tradurre come la non perfetta illuminazione del sensore, ma anche questa può essere compensata. Quel che si deve fare in questi casi è trovare il fattore di decadimento della luce in un determinato punto (espresso in percentuale) rispetto al valore massimo di illuminazione (al centro dell’immagine). Spieghiamolo meglio con i numeri analizzando l’ultimo scatto di calibrazione, il FLAT FIELD! Illuminiamo in modo uniforme il sensore ponendo sopra al telescopio una lavagnetta luminosa a led progettata per tale scopo. Questa lavagnetta si illumina in modo uniforme e perciò “DOVREBBE” permetterci di scattare una foto con la stessa illumunizaione su tutto il campo, ergo, stessi valori in ADU su tutta l’immagine. Sbagliato! Abbiamo detto che il cammino ottico del nostro strumento ci restituirà un’immagine più chiara al centro e più scura ai bordi, ma è proprio quello che ci serve per calibrare i LIGHTS. Per acquisire un buon FLAT non siamo vincolati ad usare la stessa temperatura, gain e tempi di scatto dei LIGHT, ma ci interessa solo creare un’immagine con un’istogramma il più stretto possibile che si attesti tra la metà ed 1/3 degli ADU supportati dalla nostra camera. Per farlo possiamo giocare sui tempi di posa, sulla luminosità della lavagnetta o entrambi. Un’altra tecnica molto usata è quella di porre una maglietta bianca ben tesa al posto della lavagna e puntare da lontano una torcia perfettamente in asse col telescopio. In questo caso però dovremo regolarci solo con i tempi di scatto per avere il picco in ADU sempre tra tra 1/3 e metà istogramma.

Effettuato lo scatto vedremo materialmente comparire la vignettatura del nostro strumento e su questo scatto possiamo fare le prove che ci servono per dimostrare come funziona un FLAT FIEL!!! Prendiamo come riferimento il pixel più luminoso al centro dell’immagine e diamo per assunto che questo misuri 3000 ADU. Questo è il 100% dell’illuminazione che arriva sul sensore. Se il pixel di riferimento però fosse un pixel caldo avremo un valore di riferimento sbagliato, per cui sarebbe formalmente più corretto prendere un piccolo insieme di pixel al centro e stimare la loro media. Questo sarà un valore molto più attendibile da considerare come 100% di illuminazione. Per semplicità mettiamo che il valore medio sia sempre 3000 ADU e che quindi il pixel di cui parlavo prima non fosse un pixel caldo. Ora prendiamo come riferimento un pixel sul bordo dell’immagine e misuriamone il valore per arrivare al fattore di decadimento. Se misurasse 1500 ADU si capirebbe subito che il decadimento è stato del 50%… infatti 1500 è la metà di 3000.

Ho preso d’esempio valori molto facili per spiegare il concetto, ma noi dobbiamo arrivarci con la matematica perchè non sempre i valori misurati sono cosi’ comodi. L’operazione che ci permette di calcolare il decadimento di luce è: VALORE PIXEL DI RIFERIMENTO / VALORE MEDIO DEI PIXEL AL CENTRO. Considerando il pixel B dell’immagine sopra, in numeri otteniamo 1500/3000=0,5 dove 0,5 è il nostro 50%. Se invece prendiamo come riferimento un pixel che misura 1000 ADU e che chiamiamo C avremo 1000/3000=0,333 che vale il 33,3% della luminosità massima, cioè 1/3, ed il decadimento di luce in questo caso è del 66,66%, cioè di 2/3. Essendo il decadimento di luce uguale sia sul FLAT che sul LIGHT ora posso calibrare il LIGHT sftuttando i FATTORI calcolati sul FLAT. Prendiamo il valore in ADU del pixel sul LIGHT, lo dividiamo per il FATTORE calcolato prima sul pixel suo omonimo nel Flat ed il gioco è fatto. In formule viene cosi’:

PixLIGHT / (PixFlat/Media PixelsCentraliFlat) = PixLIGHT CALIBRATO

Facendo questa operazione pixel per pixel su tutta l’immagine magicamente tutto il LIGHT verrà calibrato e d il risultato finale sarà un’immagine “piatta”… priva cioè di vignettatura ed uniforme su tutto il campo! Ora si capisce perchè quando si parla di flat si sente sempre dire che essi lavorano per divisione! Una cosa importante da fare prima di applicare il flat è calibrarlo a sua volta con un FLAT DARK per togliere tutte le componenti addiditive. Cosa vuol dire componenti additive? Le componenti additive altro non sono che i rumori termici, di lettura e di offset che abbiamo esposto sopra e che si sommano ai flat per addizione; vanno quindi eliminati per sottrazione usando un FLAT DARK, ed un FLAT DARK non è altro che un DARK con stessi tempi, gain e temperatura del flat ma al buio!! Quindi come si calibra un LIGHT con il suo DARK anche un FLAT si calibra col suo FLAT DARK. Tolte tutte le componenti additive avremo le misurazioni “pure” della luce sul sensore da cui ottenere gli indici di decadimento. In questo modo il flat funzionerà alla grande! NOTA: la formula sopra teneva conto di usare FLAT già calibrati. Se fossero stati ancora da calibrare la formula estesa sarebbe questa:

Pure la sporcizia sulle lenti o sul sensore crea uno sbarramento alla luce che genera un decadimento di luminosità. Bene! Il FLAT rileverà e rimuoverà anche questi difetti dai nostri LIGHT. Una cosa importantissima affinché i FLAT funzionino è non spostare mai nessun elemento del treno ottico tra l’acquisizione di light e flat. Neppure la messa a fuoco deve essere cambiata; se quando ho acquisito i light un granello di polvere era in una certa posizione, ruotando la camera o un filtro la sua posizione risulterà diversa nel caso andrò ad acquisire i FLAT in un secondo momento. Pure la vignettatura potrebbe risultare diversa. Stesso discorso per la messa a fuoco: variando la messa a fuoco il granello di polvere può risultare più grosso e sfocato oppure più piccolo e scuro rispetto agli scatti precedenti.

Per creare il MASTER FLAT DARK usare l’istanza ImageIntegration con gli stessi parametri usati per BIAS e DARK. Con questo calibriamo ogni singolo FLAT usando ImageCalibration. I FLAT calibrati saranno poi finalmente integrati con ImageIntegration seguendo queste regole:

- I flat, a differenza di BIAS e DARK, essendo immagini di luce come i LIGHTS (anche se acquisiti in modo particolare) devono avere dei valori normalizzati per poter avere degli istogrammi comparabili e restituire una media affidabile. Per questo è ottima la normalizzazione moltiplicativa.

- Disattivare il peso dei frames.

- Anche per integrare I FLATS bisogna attivare la rejection al fine di eliminare gli Outliers. Scegliere l’algoritmo di rigetto in base alla quantità di flat acquisiti.

- La normalizzazione che permette un buon funzionamento della rejection in questo caso è “Equalize Fluxes”.

–

–

–

Questo articolo è frutto di una lunga ricerca sostenuta da fonti e confronti con personalità illustri e vuole essere il mio vademecum personale, una guida cui farò riferimento quando mi verranno dei dubbi o inizierò a scordare alcuni concetti. Era per me importante anche condividerla, in modo tale che possa essere d’aiuto pure ad altri astrofotografi costretti all’auto-formazione come me. Imprecisioni, correzioni ed osservazioni sono accolte a braccia aperte in modo da avere un documento sempre aggiornato ed affidabile consultabile da tutti.

Per mesi mi sono chiesto quali operazioni facesse effettivamente il software durante la calibrazione; soprattutto mi chiedevo cosa volesse dire che il flat calibra per divisione! Pensavo che si dovesse “aggiungere” un certo valore per compensare la vignettatura, cosa alquanto difficile da ottenere in questo modo, in quanto i flat non sempre hanno gli stessi valori di luminosità e sopratutto non è detto che siano proporzionali ai light! Sperando di aver reso più semplice anche a voi la comprensione di questi meccanismi un po’ ostici ora siamo pronti pronti a lanciarci nell’elaborazione dei futuri scatti con una consapevolezza nuova e non brancolando nel buio o seguendo pedissequamente i vari tutorial che si trovano online. Spero quindi di esservi stato utile!

Ai prossimi articoli e cieli sereni a tutti 🙂

Simone Lochi

simonelochivisualarts.com

Grazie per questa preziosa sintesi. Complimenti.

Mario

"Mi piace""Mi piace"